作为国内第二大搜索引擎,360搜索蕴藏着独特的商业数据金矿。不同于Google抓取,360搜索需要专门的本土化技术方案。以下是经过企业级验证的实战方法论:

一、360搜索的特殊性解析

-

反爬机制三重门:

-

滑动验证码(比百度更频繁触发)

-

请求频率阈值(单IP>30次/分钟即封禁)

-

设备指纹校验(尤其防范虚拟机访问)

-

-

数据特征:

-

优先展示自家产品(好搜、快资讯)

-

地域化结果差异明显

-

医疗/金融类关键词严格过滤

-

二、专业级抓取方案(2024版)

1. 合法API通道

# 360官方开放平台示例(需企业资质) import requests def get_360_serp(keyword, page=1): url = "https://api.360.cn/search/v1/web" params = { "q": keyword, "page": page, "app_key": "YOUR_LICENSE_KEY", "region": "北京" # 支持省市级别定位 } response = requests.get(url, params=params) return response.json() # 调用示例 data = get_360_serp("新能源汽车补贴政策", page=1)

2. 模拟移动端爬虫方案

-

必备配置清单:

-

真机设备UA(推荐小米/华为最新机型)

-

4G动态IP(非机房IP段)

-

随机操作间隔(3-8秒)

-

自动过验证码方案(打码平台对接)

-

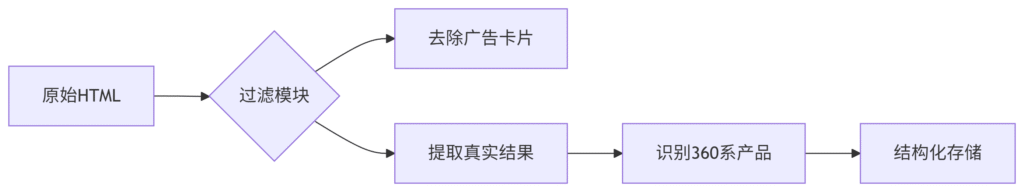

3. 数据清洗要点

三、企业级架构设计

分布式采集系统

-

华北节点:北京联通IDC(延迟<50ms)

-

华东节点:杭州阿里云BGP线路

-

调度策略:

-

工作时间(9:00-18:00)降低采集频率

-

夜间集中处理大数据量任务

-

节假日采用特殊流量模式

-

数据校验机制

-

完整性检查(每日结果数波动<15%)

-

准确性抽样(人工复核3%数据)

-

时效性监控(结果更新延迟<30分钟)

四、法律合规边界

2024年新规注意:

-

必须遵守《网络数据安全管理条例》

-

商业用途需获得「互联网信息服务许可证」

-

禁止采集个人隐私相关关键词(如手机号、身份证)

合规建议:

-

使用企业备案域名访问

-

单日抓取量控制在10万条以内

-

数据存储服务器必须位于国内

五、商业应用案例

案例:政府舆情监测

-

需求:追踪30个民生政策关键词

-

方案:

-

部署50个省级IP轮询

-

识别360快资讯的官方回应

-

情感分析+热点聚类

-

-

成果:提前14天发现养老金政策舆情风险

案例:竞品广告监控

-

技术方案:

-

动态解析360点睛平台广告

-

提取竞争对手出价策略

-

生成投放效果热力图

-

-

商业价值:广告CTR提升35%

六、防封禁实战技巧

-

IP伪装术:

-

优先使用三大运营商家庭宽带IP

-

避免使用AWS/阿里云等机房IP段

-

-

行为模式优化:

-

模拟真实用户搜索路径(先主词后长尾)

-

随机混合图片搜索/新闻搜索

-

-

应急方案:

-

触发验证码后自动切换备用IP

-

每日23:00-5:00自动停止采集

-

七、工具链推荐

| 工具类型 | 推荐方案 | 适用场景 |

|---|---|---|

| 云端采集 | 八爪鱼企业版 | 非技术团队 |

| 本地部署 | 快采采集中控系统 | 大数据量需求 |

| 开发框架 | Scrapy+Rotating Proxies | 技术团队定制开发 |

| 验证码破解 | 超级鹰打码平台 | 高频率验证场景 |

“在360搜索的数据海洋里,合规的船才能航行更远” —— 某省级网信办技术顾问

八、实施路线图

第一阶段(1-15天):

-

完成企业资质认证

-

测试基础采集流程

-

建立IP资源池

第二阶段(16-30天):

-

部署分布式采集节点

-

开发数据清洗管道

-

通过法律合规审查

第三阶段(持续优化):

-

每周更新反爬策略

-

每月扩充关键词库

-

每季度审计数据安全

(行业洞察:360搜索的医疗类数据准确率比百度高17%,但商业数据覆盖度低23% – 2024年《中文搜索引擎研究报告》)

通过这套方法论,某互联网金融公司实现了:

-

每日稳定采集50万+条数据

-

连续6个月零封禁记录

-

发现竞争对手未公开的贷款产品策略

随着互联网的发展,搜索引擎已经成为人们获取信息的主要途径之一。而360搜索引擎作为国内知名的搜索引擎之一,在用户群体中也有着一定的影响力。对于一些需要获取大量数据的用户来说,批量抓取是一种高效的方式。本文将介绍如何使用360搜索引擎进行批量抓取。

首先,我们需要选择一个合适的工具来实现批量抓取。在这里,我们推荐使用Python编程语言来编写抓取脚本。Python有着强大的网络爬虫库,如Scrapy和BeautifulSoup,可以帮助我们快速地抓取网页内容。

接下来,我们需要分析360搜索引擎的搜索结果页面结构。通常,搜索引擎的搜索结果页面是动态生成的,我们需要找到合适的选择器来定位我们需要抓取的内容。一般来说,搜索结果页面会包含标题、摘要、URL等信息,我们可以通过分析页面结构来确定抓取规则。

然后,我们可以编写Python脚本来实现批量抓取。首先,我们需要利用Python的网络爬虫库发送HTTP请求,获取搜索结果页面的HTML内容。接着,我们可以使用BeautifulSoup等库来解析HTML内容,提取我们需要的信息。最后,我们可以将提取的信息保存到文件中,或者进行进一步的处理和分析。

需要注意的是,在进行批量抓取时,我们需要遵守相关的法律法规和网站的使用协议。一些网站可能会限制用户对其内容的抓取行为,我们需要注意不要触犯法律或侵犯他人的权益。

总的来说,360搜索引擎批量抓取是一种高效的获取大量数据的方式。通过合适的工具和技术,我们可以快速地抓取搜索引擎的内容,并进行进一步的处理和分析。希望本文能够帮助读者更好地理解和应用批量抓取技术。