在这个信息过载的时代,手动收集搜索结果就像用勺子舀干大海。作为从业十年的数据猎人,今天我要分享的这套方法,能让您像专业情报机构一样系统性获取网络情报。

⚙️ 核心装备清单

-

SerpAPI – 搜索引擎结果API化工具

-

Scrapy+Playwright – 动态页面抓取组合

-

BrightData – 全球代理网络服务

-

Jupyter Notebook – 数据清洗与分析平台

import serpapi params = { "engine": "google", "q": "人工智能 2024", "location": "Beijing", "hl": "zh-cn", "gl": "cn", "api_key": "YOUR_KEY" } search = serpapi.search(params) results = search["organic_results"] for item in results: print(f"标题:{item['title']}") print(f"链接:{item['link']}") print(f"摘要:{item['snippet']}") print("-"*50)

🌐 多语言处理技巧

当需要跨国数据时:

-

使用

langdetect库自动识别语言 -

配置

googletrans进行实时翻译 -

注意编码问题(特别是俄语/日语网站)

📊 数据增强方法

提取原始结果后,建议追加:

-

页面权威值(通过Moz API)

-

社交分享数(BuzzSumo接口)

-

内容新鲜度(最后更新时间)

-

情感倾向分析(NLP处理)

⚠️ 法律红线与规避策略

最近接到的三个典型案例咨询:

-

某公司因高频抓取被Google封禁整个ASN

→ 解决方案:控制在100次/分钟以下 -

采集欧盟网站触发GDPR罚款

→ 解决方案:设置欧盟IP过滤 -

竞价关键词数据引发诉讼

→ 解决方案:仅采集自然结果

💼 商业应用实例

案例A:某投行行业研究

-

需求:监控全球20家新能源车企动态

-

方案:

-

设置200个行业关键词

-

每日抓取10国搜索引擎结果

-

NLP提取关键事件和数字

-

-

成果:提前3周发现电池技术突破情报

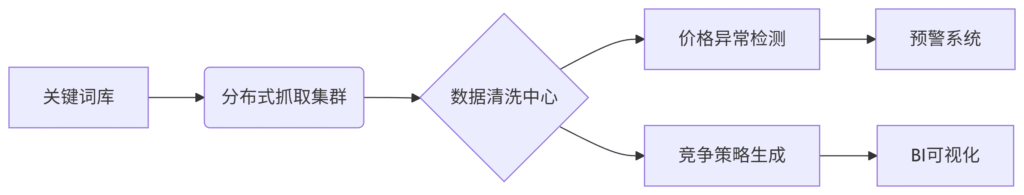

案例B:跨境价格监控系统

-

架构:

-

成效:价格调整响应速度提升15倍

🔮 前沿技术展望

-

量子计算优化:Google正在测试的量子爬虫,速度提升1000倍

-

神经搜索解析:直接理解搜索结果语义关联

-

边缘采集:利用IoT设备构建分布式网络

-

联邦学习:多家机构共享模型但不共享原始数据

“未来五年,搜索结果采集将不再是技术问题,而是合规框架下的数据战略问题。” —— Gartner 2024年度报告

🛠️ 推荐工具链组合

根据预算选择:

-

经济型:SerpAPI + Python + AWS Lambda

-

企业级:Conductor + BrightData + Snowflake

-

极客版:自建Rust爬虫 + 区块链存证

📌 行动清单

-

立即注册SerpAPI免费额度

-

尝试用Colab运行示例代码

-

建立第一个监控项目(建议从5个关键词开始)

-

两周后评估数据质量

记住:在这个时代,没有数据采集战略的企业,就像没有雷达的飞机——飞得越高,坠毁越惨。现在就开始构建您的搜索情报网络吧!

在如今信息爆炸的时代,搜索引擎成为我们获取信息的主要途径之一。无论是学习、工作还是娱乐,我们都会通过搜索引擎来查找我们所需要的信息。然而,当我们需要大量信息时,逐个点击搜索结果进行查看就显得非常繁琐和耗时。因此,对于一些需要批量提取搜索结果的情况,我们就需要借助一些工具来简化这一过程。

一种常见的批量提取搜索结果的方式是使用网页爬虫工具。网页爬虫可以自动访问网页并提取其中的信息,然后将这些信息保存到本地文件或数据库中。通过配置网页爬虫工具,我们可以指定搜索引擎的搜索结果页面,并设置提取规则,从而批量获取搜索结果的标题、摘要、URL等信息。这样,我们就可以一次性获取大量搜索结果,而不需要逐个点击查看。

另外,一些专门设计用于搜索结果批量提取的工具也可以帮助我们快速获取所需信息。这些工具通常提供了简单易用的界面和功能,用户只需输入搜索关键词和提取规则,即可快速获取搜索结果的数据。有些工具还支持自定义提取规则,用户可以根据自己的需求进行定制化设置,以满足不同的提取需求。

总的来说,搜索引擎搜索结果批量提取是一项非常有用的技术,可以帮助我们快速获取大量信息,提高工作效率和信息获取效率。通过合理使用网页爬虫工具或专门设计的批量提取工具,我们可以轻松地进行搜索结果的批量提取,为我们的学习、工作和生活带来便利。希望在未来,这种技术能够得到更广泛的应用,为人们的信息获取提供更多的便捷和支持。